在Multimedia Systems(JCR Q1、CCF-C)上发表了一篇文章,关于Multimodal federated learning。为了提供全面的视角,整理了大量的相关工作,总结在Github仓库,希望能为MMFL的发展出一份小力。本页面提供该文章的中文摘要。

摘要

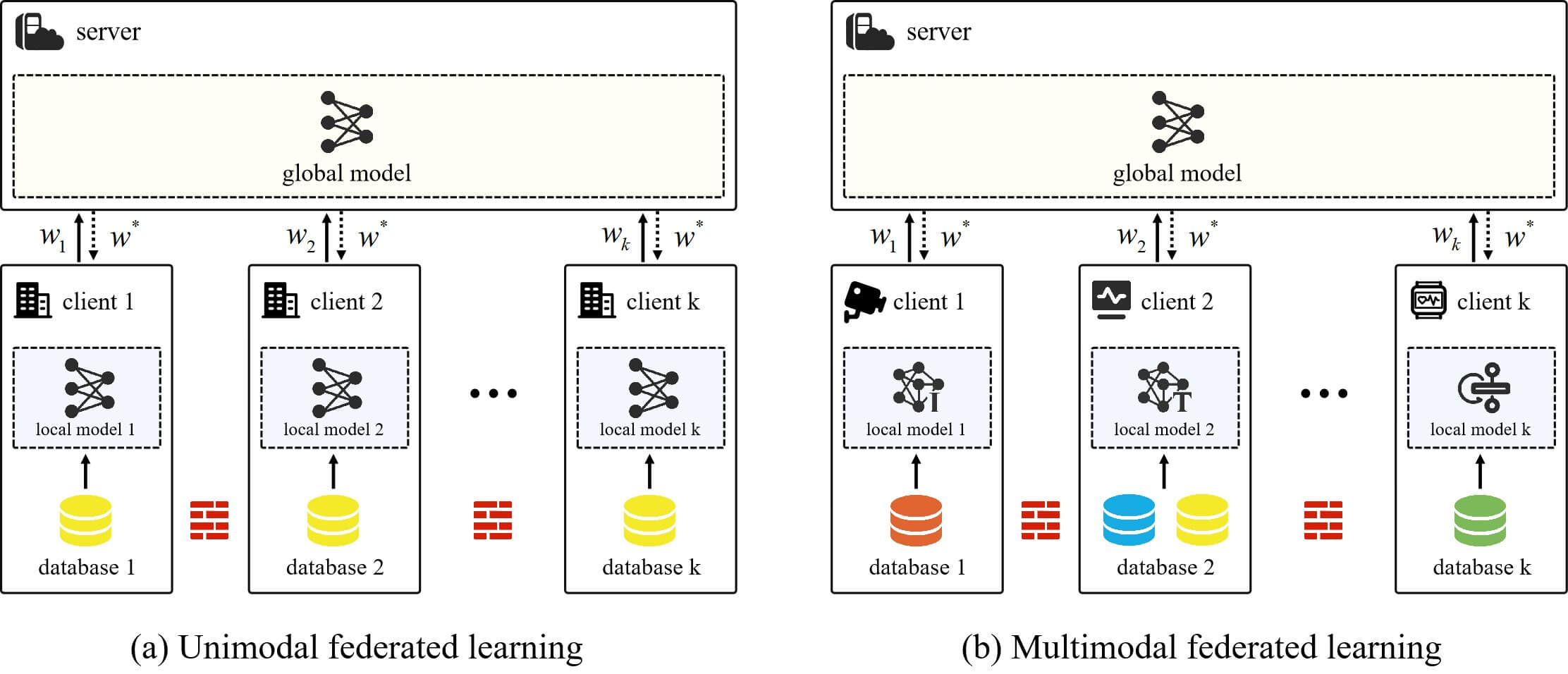

多模态联邦学习(MMFL)是一种全新的机器学习技术,它增强了传统联邦学习(FL)的能力,允许多个本地模型使用各种模态的数据进行协作训练。随着互联网、传感器和移动设备产生和存储的多模态数据的快速增长,以及人工智能模型的快速迭代,业界对多模态模型的需求正在迅速增长。尽管在过去几年里人们对联邦学习进行了广泛的研究,但大多数现有研究都是基于单模态设置的。为了激发更多关于MMFL的应用和研究,我们全面回顾了大量先进的MMFL方法在各方面取得的进展和面临的挑战。具体而言,我们分析了MMFL的研究动机,针对现有研究提出了一种新的分类方法,讨论了可用的数据集和应用场景,并在最后对MMFL面临的机遇和挑战提出了许多观点。

Fig1: Illustration of federated learning and multimodal federated learning