整理了一下大模型与多模态大模型的技术路线,包括基础课程、经典教材、开源项目等。

1.什么是大模型

大模型全称是大型语言模型(Large Language Model, LLM),指具有超大规模参数量(通常超过十亿个)的深度神经网络模型。

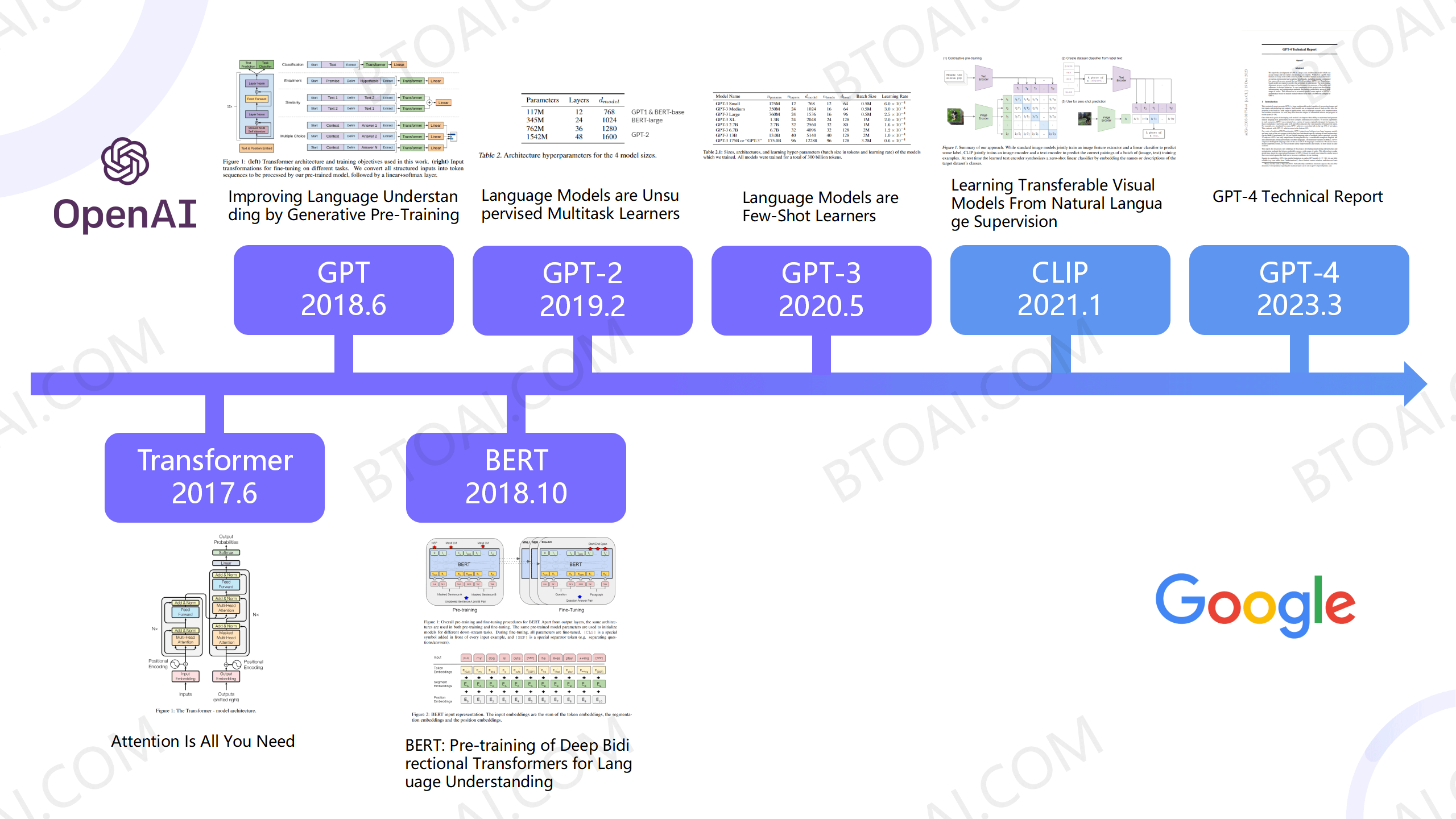

大模型是自然语言处理(NLP)领域的重要技术分支,从技术角度来看,大模型特指近年来以Transformer架构(谷歌2017年首次提出)为核心的超大规模神经网络模型,相比于传统的NLP技术,大模型性能更好,但对算力要求高、可解释性弱[1]。

2.基础知识

① 高等数学与Python

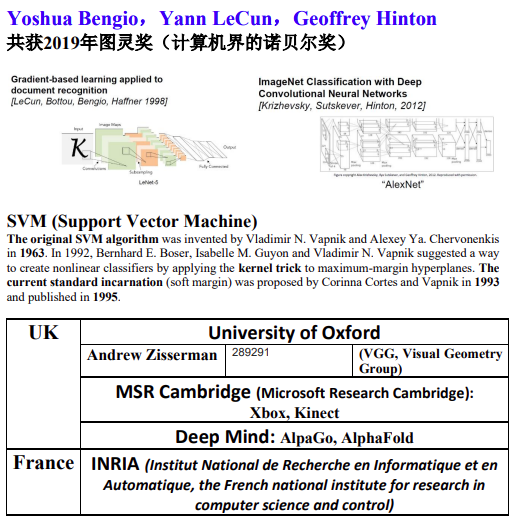

② 机器学习(《机器学习-周志华》)

③ 深度学习(《动手学深度学习-李沐》[2])

④ 经典论文:

注意力Attntion机制与Transformer结构(Attention is All You Need, 2017 Google[3])

GPT结构(只使用 Decoder )(Improving Language Understanding by Generative Pre-Training, 2018 OpenAI[4])

BERT结构(只使用 Encoder )(BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding, 2018 Google[5])

GPT2 (Language Models are Unsupervised Multitask Learners, 2019)

GPT3 (Language Models are Few-Shot Learners, 2020)

⑤ 开源课程:

开源大模型食用指南 (GitHub)[6]

大模型基础理论 (GitHub) [7]

从零开始的大语言模型原理与实践教程 (GitHub)[8]

3.大模型排行榜

每个月都会有新的大模型开源或发布,目前主流的排行榜是Open LLM Leaderboard (Hugging Face),但是国内无法访问。

其次是Lmsys Chatbot Arena Leaderboard,现在叫LMArena [9],推荐参考。

中国的排行榜是司南OpenCompass [10],更新较慢。