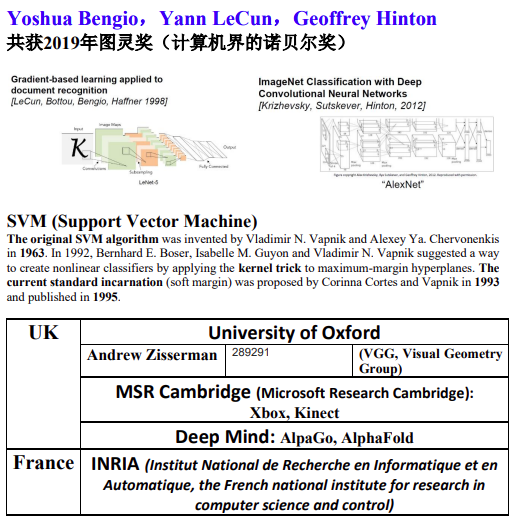

来源:南航李丕绩(百度 无觅 腾讯AI LAB)464页演示文稿ChatGPT_ppf.pdf、使用ChatGPT(3.5turbo)对关键词进行解释

1.AI十年回顾

1.1 AlphaGo

DeepMind成立于2010年,2014年被Google收购。

2014年开始开发人工智能围棋软件AlphaGo。

2015年10月,分布式版AlphaGo分先以5:0击败了欧洲围棋冠军华裔法籍职业棋士樊麾二段。

2016年3月,AlphaGo挑战世界冠军韩国职业棋士李世乭(이세돌)九段,对弈结果为AlphaGo 4:1战胜了李世乭。

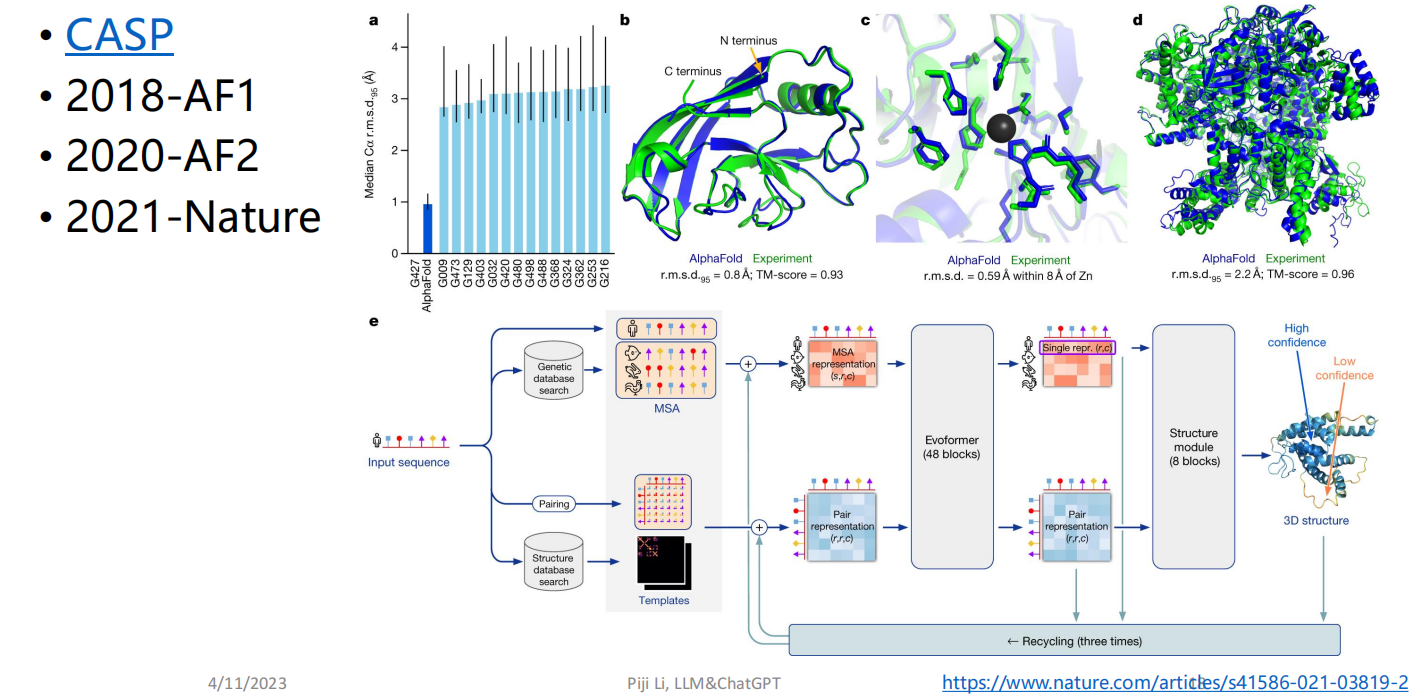

1.2 AlphaFold 蛋白质折叠,预测蛋白质结构

1.3 Diffusion Model 作画

1.4 ChatGPT / GPT4 对话 大语言模型

2.自然语言处理

2.1 AI研究的是什么?

• 机器学习

• 计算机视觉

• 自然语言处理

• 语音识别及合成

• 机器人

2.2 NLP

自然语言处理 (Natural Language Processing, NLP) 是利用计算机技术来分析、理解和处理自然语言的一门学科, 涉及到语言学、计算机科学、人工智能等交叉领域,关注计算机和人类(自然)语言之间的交互。

可分为自然语言理解 (Natural Language Understanding, NLU) 和自然语言生成 (Natural Language Generation, NLG)两大部分。

*自然语言:人类使用的语言,如汉语、英语、法语等;特指文本符号(非语音)。

2.3 NLP属于认知智能

*计算智能(能存会算),感知智能(能听会说,能看会认),认知智能(能理解会思考,需要抽象和推理能力)。

2.4 NLP技术难点

• 歧义性

• 主观性

• 创新性

• 知识性

• 组合性

• 上下文

• 多模态

3.ChatGPT技术分析

3.1 基础技术

Language Model:根据样本给出概率分布。其核心思想是给定一些上下文,预测下一个单词或短语的概率。例如,在给定“我喜欢吃冰淇淋”的前提下,一个好的语言模型可以预测到“在夏天”这样的短语出现的可能性更高。

N-gram LM:基本思想是计算给定N-1个前一个单词序列的下一个单词的概率。通过统计训练文本中每个单词的出现次数并基于这些计数来估计概率来实现的。广泛应用于许多自然语言处理应用程序,例如语音识别,机器翻译,文本生成和拼写纠正。

Evaluation: Perplexity:评估是NLP中重要的环节,在NLP任务中,常见的评估指标包括精确度、召回率、F1得分、准确度、困惑度、BLEU评分等。Perplexity困惑度,是一种用以反映模型对于测试数据集的预测能力的度量,衡量模型在对未见数据进行预测时的不确定性。困惑度的计算方法基于信息论中的熵的概念,可用于度量一个语言模型在测试数据上的预测准确程度。一般情况下,如果一个语言模型在测试数据集上的困惑度越低,说明该模型需要表示被预测序列的比特数更少,即该模型对测试数据的预测更加准确。

NN LM:神经网络语言模型 (Neural Network Language Model),是一种由神经网络驱动的语言模型。与传统的机器学习方法中的N-gram语言模型不同,NN LM使用神经网络来预测下一个单词或下一个字符。在神经网络语言模型中,输入是前N个单词或字符,输出是下一个单词或字符的概率分布。

*NNLM难以处理长期依赖关系,即在处理上下文中,如果上下文窗口的大小被限制在5或10个单词(或字符)之内,这可能会导致模型无法考虑到先前的多个回合,从而引发上下文理解的问题。但可以通过循环神经网络RNN来解决。

Long Short-Term Memory:梯度消失和梯度爆炸是深度神经网络中的两个常见问题。长短时记忆 (Long Short-Term Memory, LSTM) 是一种常用于处理序列数据的深度神经网络架构。LSTM是一种特殊类型的循环神经网络,旨在克服常规循环神经网络中的梯度消失问题、实现更好的长距离依赖性建模、同时具有更强的泛化能力。由于LSTM可以克服循环神经网络中的梯度消失问题、允许处理更长的输入序列,使得其在文本分类、机器翻译、语音识别等自然语言处理领域以及人工智能的其他领域中具有广泛的应用价值。(现在用的少了)

GRU:门控循环单元 (Gated Recurrent Unit, GRU) 是一种近年来广泛应用于处理序列数据的深度神经网络架构。GRU与LSTM类似,也是一种具有门控机制的循环神经网络,旨在处理序列数据中的长距离依赖性。GRU在LSTM的基础上进行了一些简化和优化,省略了一些门,这使得GRU拥有更简单更快速的训练速度和更少的参数。

3.2 RNN应用

包括自然语言生成、语音识别、文本分类、语音合成、词向量表示。

Word2Vec:是一种流行的词向量算法,它利用神经网络来生成高效率的词向量表示。Word2Vec算法比单纯独立地考虑一个词本身更关注该词在上下文中的含义。Word2Vec有两种不同的实现方式:连续词袋模型(Continuous Bag of Words, CBOW)和Skip-Gram模型。通过这两个模型,Word2Vec可以将每个单词映射成向量,并用于各种自然语言处理任务,例如文本分类、情感分析和机器翻译等。

机器翻译:统计机器翻译 (Statistical Machine Translation) SMT。统计机器翻译是一种基于数据和模型的传统机器翻译方法,它通过统计分析来判断不同语言之间单词、短语和句法图之间的联系,然后进行翻译,因此需要大量的平行语料库作为训练数据。过时,目前主流神经机器翻译 (NMT)。

RNN Encoder-Decoder模型是一种经典的序列转换框架,常被用在机器翻译、自然语言处理、图像标注等领域。

Sequence-to-Sequence with Attention (Seq2Seq-Attention) 是一种流行的序列转换模型,它使用了注意力机制来解决长序列翻译过程中信息交互的问题。Attention Calculation(注意力计算)是在Seq2Seq-Attention模型中实现一种新的机制,用于选择编码器输出中的重要部分。

Seq2seq-attention之后,大厂开始业务上线

在线翻译(谷歌、微软、百度、有道、搜狗等)

翻译机(百度、搜狗、科大讯飞、准儿等)

同传机器翻译(微软、腾讯、搜狗、讯飞等)

•基于PowerPoint的语音同传(微软,TAUS 3.22-23 )

•面向自由说话人的语音同传(腾讯,博鳌亚洲论坛)

ConvS2S (Convolutional Sequence to Sequence) 是一种新兴的序列建模方法,在自然语言处理和语音识别等领域中具有重要应用。ConvS2S模型和基于RNN的Seq2Seq模型相比,具有以下优点:

1.相对于RNN模型而言,计算速度相对更快,可以更有效地处理长序列。

2.可以并行处理不同的输入序列,从而在处理大规模数据集时更加高效。

Transformer是一种流行的神经机器翻译模型,效果优于传统的循环神经网络 (RNN) 和卷积神经网络 (CNN)。相对于RNN和CNN,Transformer采用了一种名为自注意力机制(self-attention mechanism)的新型技术,能够捕获更长的上下文依赖信息,从而提高了序列建模的效果。Google

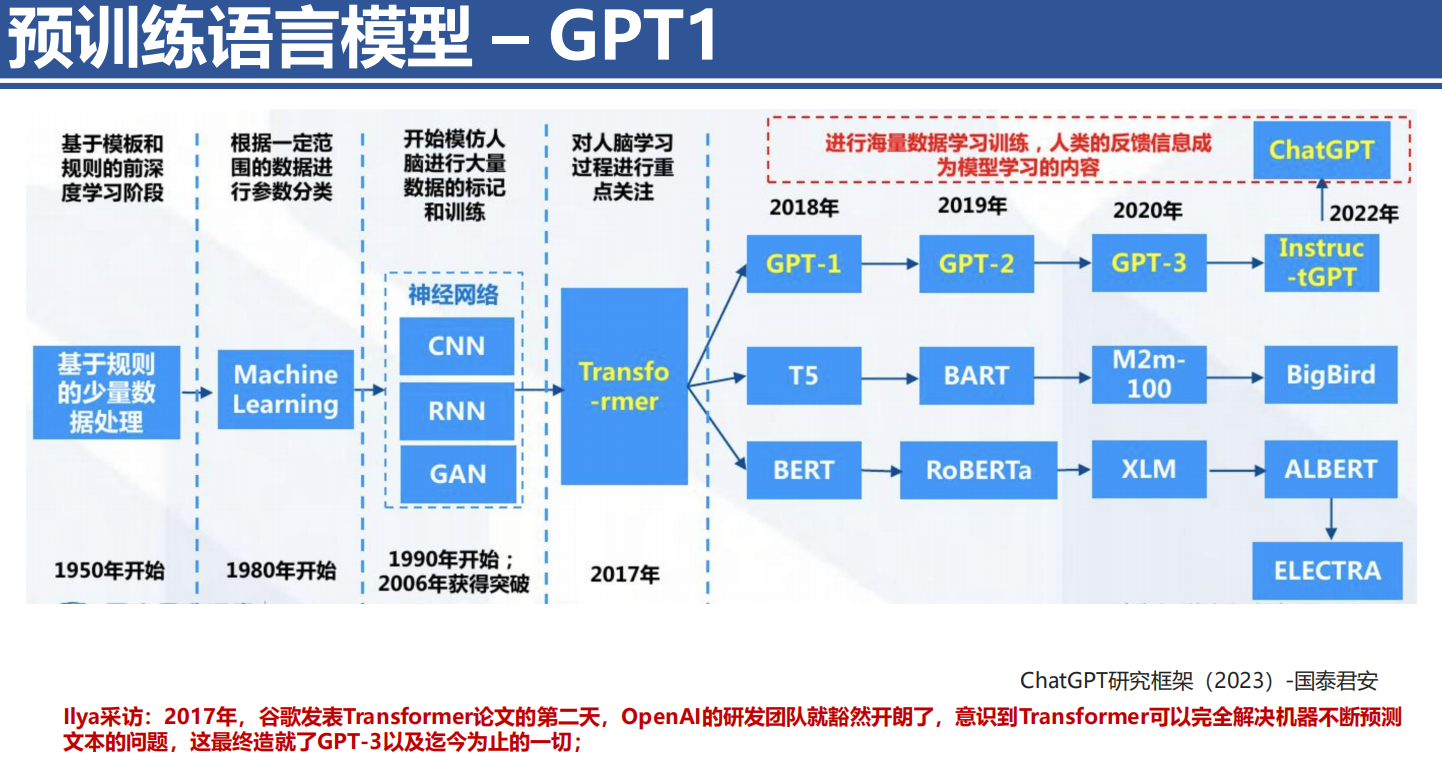

3.3 预训练技术

语义分析

VSM→LDA(2003)

→Google Word2vec(2013/14) → Google LSTM-LM(2015)

→ AI2 ELMo(2017) → OpenAI GPT(Jun 2018)

→ Google BERT(Oct 2018) → OpenAI GPT2(2019)→ Google XLNet(2019)

→OpenAI GPT3(2020)

看不懂咯🙂主要是向量表示和无监督学习之类的技术。

GPT(Generative Pre-trained Transformer)是一个基于Transformer结构,使用自注意力机制实现的预训练语言模型,由OpenAI开发。GPT模型的目的是通过预训练生成自然语言的“上下文”,以利用这些生成的“上下文”来更好地完成各种自然语言处理任务。GPT中的三个字母,每一个的技术or专利都属于Google或者是被Google早期探索过,但合起来就是OpenAI的。

BERT (Bidirectional Encoder Representations from Transformers) 是一种由Google开发的预训练语言模型,通过无监督学习方式,为各种自然语言处理任务提供高效的文本表示。BERT是一种双向语言模型,使用了自注意力机制自动学习一个给定文本中的单词表示,而不同于传统的非双向语言模型,BERT考虑了以前和以后所有的上下文信息,在输入文本中每个位置生成了一个定长的向量表示。BERT的输入是一段文本,通过多层双向Transformer进行处理得到对应的向量表示,然后可应用于许多自然语言处理任务中。

BERT的突破性在于,使用大规模的无标注数据集来预先训练语言模型,然后再通过有监督或半监督学习的技术进行微调来适应特定任务。这使得BERT模型可以在执行多个自然语言处理任务时不用对模型结构进行太多修改,而且效果显著。

BERT的面向应用领域极其广泛,如文本分类、命名实体识别、文本摘要、机器翻译、问答等等。BERT的训练和使用已经成为人工智能自然语言处理领域的基础技术之一,且在单个模型上取得了世界上许多自然语言处理任务的最佳性能。BERT是一种高效的预训练语言模型,利用自注意力机制充分学习文本的上下文信息,在各种自然语言处理任务中取得了突出的效果,目前已经成为自然语言处理领域的重要技术基础。

XLNet (eXtreme Language understanding NETwork) 是一种基于 Transformer 的预训练自然语言处理模型,由谷歌工程师和华为科学家开发,并在自然语言处理领域中取得了很好的成果,获得了多个任务的最佳效果。相比较于BERT,XLNet基于自回归(auto-regressive)的语言建模,同时也引入了一个全新的思想:permutation-based预训练。

不同于BERT中使用的Masked Language Model (MLM)和Next Sentence Prediction (NSP) 的形式来建立预训练目标,XLNet使用permutation-based预训练方法,通过将输入序列中的标记随机地排列生成多个可能的排列并生成条件掩码使之不再是自回归, 从而打乱输入之间的约束性,这样训练模型时可以利用更多的信息。

此外,XLNet模型用到了束搜索(beam search)算法,该算法使得模型可以选择多个可能的生成序列,这些序列潜在地能够处理输入序列中的不同上下文。 这种多源上下文感知能力和permutation-based预训练的引入,使XLNet比BERT更加适用于各种NLP应用,并取得了多项记录。

总之,XLNet是一种在自然语言处理任务中表现极佳的预训练语言模型,通过permutation-based预训练和束搜索算法,使得在多个自然语言处理任务中取得优异表现,并且具有一定的泛化能力。

RoBERTa (A Robustly Optimized BERT Pretraining Approach)是一种基于 BERT 的预训练语言模型,是由 Facebook AI 研究团队开发的。RoBERTa的目标是进一步改进 BERT 的词汇和训练方式,以提高在各种下游自然语言处理任务中的表现。

RoBERTa 采用了一个更加多样化和严格的预训练过程,与 BERT 不同之处在于:

- 改进了 BERT 的训练目标,采用连续文本技术,去掉文本噪声并增加训练数据。

- 采用巨型批量训练,RoBERTa使用更大的批量大小和更长的预训练时间,以增加模型的更新频率和优化效果。

- 增加数据随机性,随机删除和mask单词,并剪切不同长度的序列,以模拟模型在处理实际数据时的方差。

相对于 BERT,RoBERTa在自然语言处理任务中表现出更高的准确性和泛化性能,已经在多个公共自然语言处理基准测试数据集上显示出卓越的性能。

总之,RoBERTa是一种基于 BERT 的强大预训练语言模型,通过训练目标的改进、巨型批量、数据随机性等严格的训练过程,提供了改进的性能和较高的泛化能力,已经成为自然语言处理领域中流行的预训练模型之一。

*从实验效果来看,RoBERTa干过了bert和XLNet。

ERNIE-1&2:百度的语言模型。

GPT-2 OPENAI 2019年2月发布,PT-2 模型有 1.5 亿个参数,是 GPT 模型的约 15 倍。

中文GPT2于2019年3月训练完成,并在各种下游任务适配。Tencent

各种大模型的数据量。

3.4 GPT-3面临的问题

3.5 GPT-3.5 GPT-4

国内对标ChatGPT产品:文心一言(百度)、通义千问(阿里巴巴)、套壳ChatGPT(几乎所有)

国外对标ChatGPT产品:New Bing(微软接入ChatGPT实现联网)、bard(谷歌,仅支持英文)、套壳

ChatGPT无法在国内正常使用,GPT-4目前只能通过付费使用。

4.ChatGPT应用

教育领域:文本续写、文本润色、写代码、做题、查资料、论文阅读(有概率出错)

国防领域:生成培训资料、翻译、目标识别、信息战、路径规划、分析情报、编写相关程序

医疗领域:寻医问诊

互联网领域:搜索、编程、发现漏洞

娱乐领域:绘图、制作视频、写诗/歌词、聊天

商业领域:营销策划、推荐系统、商品描述、广告推荐、客服、PPT制作

法律、金融、政府……

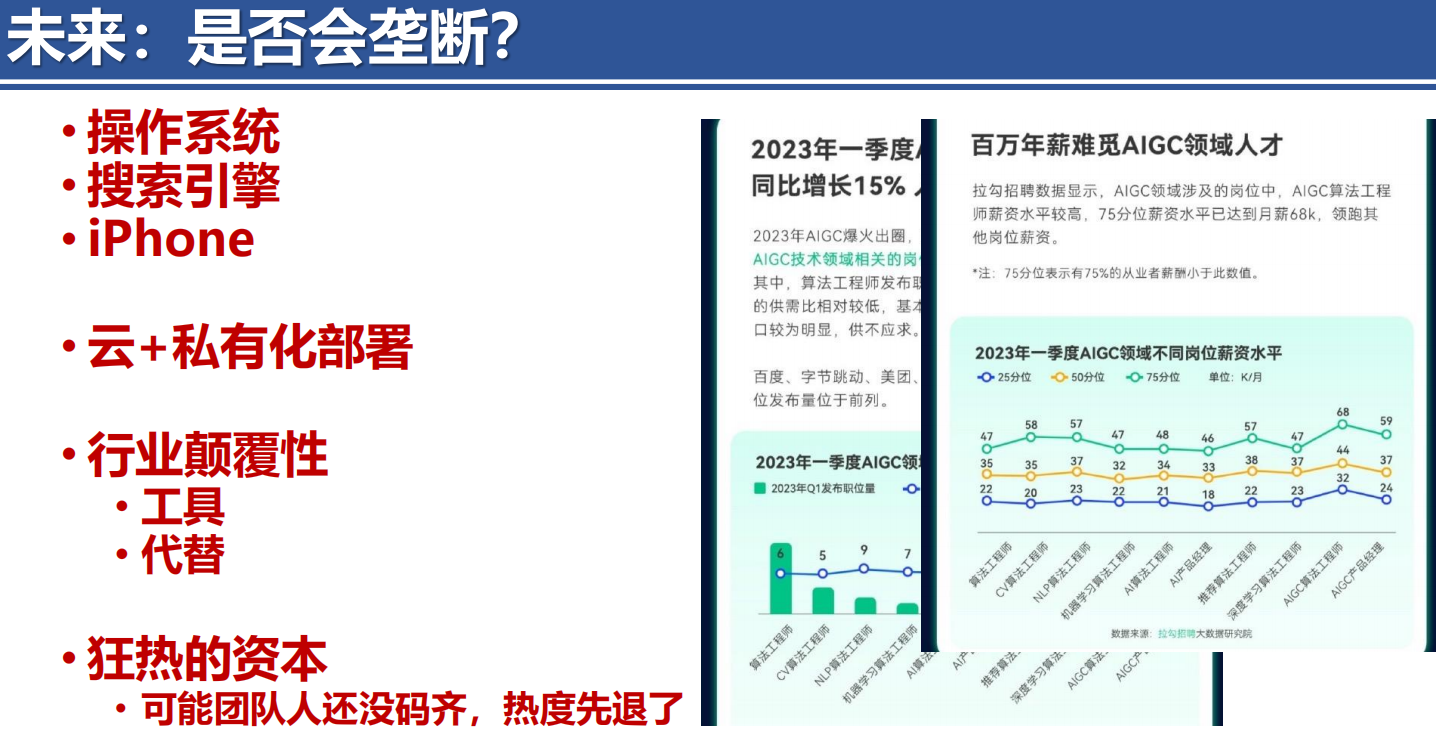

数据安全问题,技术垄断问题(一些地区无法使用)

PPT下载:

整理:Howard

最后修改时间:2023.4.17